2.2 Origem da Necessidade

No início dos sistemas de

computação, as máquinas eram muito grandes e muito caras. Eram projetadas para

realizar certo conjunto de operações que, combinadas, seriam capazes de criar

diversas aplicações. Rapidamente, vários setores da sociedade passaram a

projetar aplicações específicas nas suas áreas que usassem o poder dos

computadores. A velocidade de cálculo atingida por um circuito eletrônico em

comparação com qualquer outro método existente até a época era fascinante. O

custo, porém, incluía do preço ao espaço de armazenamento, passando por

manutenção e energia elétrica, tudo isso em uma época em que a tecnologia era

ainda um tanto limitada nesse ramo.

Pode-se fazer, inclusive, um

paralelo com relação ao nosso panorama atual. Estamos conseguindo, aos poucos

“domar” as relações quânticas e transformá-las em poder computacional. Diversos

cálculos serão possíveis a partir do momento em que pudermos usar computadores

quânticos, o que vai gerar uma demanda enorme vinda de diversos setores da

tecnologia. Certamente esbarraremos, porém, no custo desse sistema.

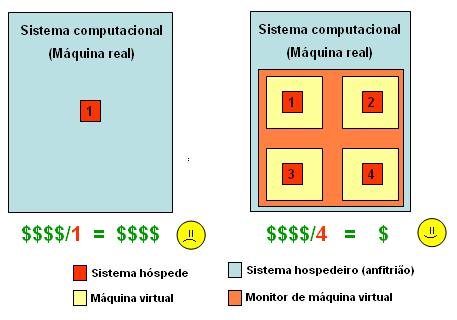

Voltando

ao cenário dos anos 50, o surgimento da virtualização propôs uma solução. A

capacidade de usar uma máquina real em várias virtuais e trabalhar nelas

separadamente implicou na possibilidade de se obter mais rendimento da máquina.

A relação custo-benefício passou a ser favorável para muitas aplicações, e a

técnica se difundiu.

A partir de então, tendo ramos

heterogêneos a desenvolver tecnologias computacionais, houve a criação de

sistemas incompatíveis. O hardware, sistema operacional e aplicações foram

desenvolvidos em empresas diferentes, talvez em tempos diferentes. Essa

característica gerou através do tempo plataformas operacionais distintas e

incompatíveis entre si. A virtualização veio à tona, então, ao criar uma

máquina virtual capaz de simular outra máquina real, onde se pode instalar

outro sistema operacional (chamado hospedeiro).

| Top

| Next

Top

| Next

1.

Introdução

1.

Introdução

1.

Introdução

1.

Introdução  2.

Histórico

2.

Histórico

3.

Classificações da Virtualização

3.

Classificações da Virtualização  3.1 Quanto à arquitetura

3.1 Quanto à arquitetura

3.2 Quanto à técnica

3.2 Quanto à técnica 3.3 Outras classificações

3.3 Outras classificações 4.

Estágio Atual

4.

Estágio Atual 5.

Perspectivas Futuras

5.

Perspectivas Futuras